Mitigation des Exchange CVE-2024-21410

Derzeit stellen sich viele Leute die Frage: Wie kann ich die Sicherheitslücke CVE-2024-21410 in meinem Exchange Server schließen? Hat die Mitigation Auswirkungen auf meine Exchange Organisation?

Nun, das ist nicht so einfach zu beantworten. Grundsätzlich gilt, um das Sicherheitsloch zu schließen muss die sogenannte Exchange Extended Protection aktiviert werden. Diese soll dafür sorgen, dass sogenannte „man-in-the-middle“ Attacken verhindert werden.

Für Exchange 2019 wird die EP mit dem CU14 aktiviert (außer der Nutzer deaktiviert das Feature wissentlich bei der Installation). Doch wie verhält es sich bei Exchange 2016?

Grundsätzlich muss sichergestellt sein, dass ein eventuell vorgeschalteter LoadBalancer kein TLS-Offloading nutzt. Im Normalfall macht ein LoadBalancer ein ReEncrypt oder einfach eine Weiterleitung der Anfragen. Sollte jedoch ein Offloading genutzt werden, wird die Konfiguration zu Problemen führen. Des Weiteren müssen alle Komponenten auf dem Exchange auf aktuellem Stand sein. Das bedeutet, dass auf dem Exchange 2016 das aktuelle CU 23 (Minimum 15.01.2507.012 / Bei Exchange 2013 Build 15.00.1497.040) installiert sein muss und TLS1.2 auf ALLEN Exchange Servern der Organisation aktiviert sein muss. Hier kann der Exchange HealthChecker helfen, um die Konfigurationen auf dem Exchange zu überprüfen.

https://microsoft.github.io/CSS-Exchange/Diagnostics/HealthChecker/

C:\TEMP>.\HealthChecker.ps1 -Server Exchange01,Exchange02,Exchange03

Für die Lesbarkeit sollte über den folgenden Befehl der HTML Report erstellt werden.

C:\TEMP>.\HealthChecker.ps1 -BuildHtmlServersReport

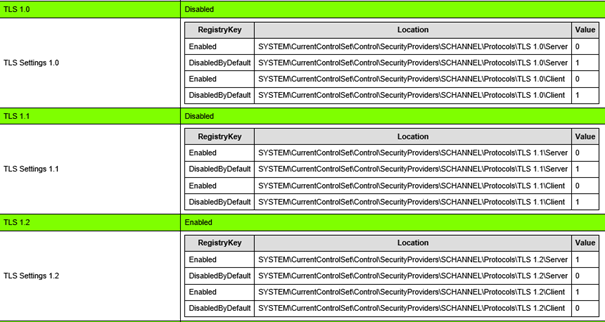

Die TLS Einstellungen auf den Servern sollten dann wie folgt ausgegeben werden (bitte für alle Server prüfen):

Zuerst einmal sollte geprüft werden, ob die EP bereits aktiviert ist. Dafür kann das PowerShell Script aus dem Microsoft GitHub genutzt werden.

https://microsoft.github.io/CSS-Exchange/Security/ExchangeExtendedProtectionManagement/

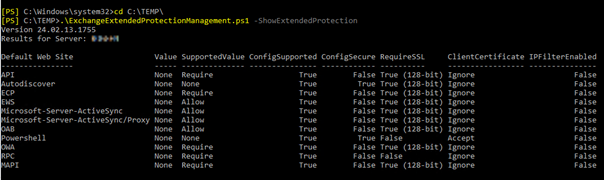

Wenn dieses Script auf einem Exchange mit dem Parameter -ShowExtendedProtection gestartet wird, werden die entsprechenden Werte ausgelesen und aufgelistet.

Wie hier zu sehen, stehen alle Werte auf „None“. Das bedeutet, dass die EP auf dem Server nicht aktiv ist.

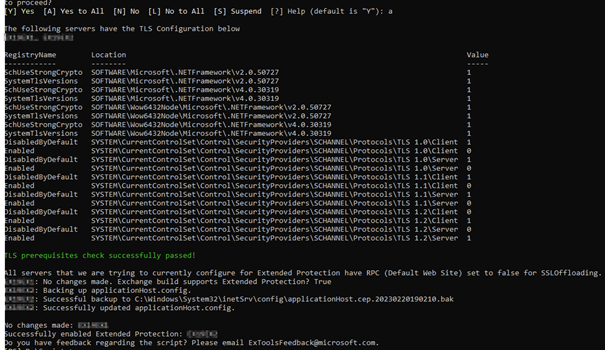

Um nun die Aktivierung der Extended Protection durchzuführen, kann das gleiche Script, ohne einen angegebenen Parameter gestartet werden.

C:\TEMP>.\ExchangeExtendedProtectionManagement.ps1 -ShowExtendedProtection

Das Script prüft nun nochmal die benötigten Einstellungen und aktiviert die benötigten Parameter, damit die EP auf den Virtuellen Verzeichnissen des Exchange aktiviert wird.

Sollte es Problem mit z.B. OutlookAnywhere bei der Ausführung des Scripts geben, muss eventuell das Offloading bei OutlookAnywhere deaktiviert werden. Dies kann wie folgt durchgeführt werden:

[PS] C:>Set-OutlookAnywhere „Exchange-XY\RPC (Default Web Site)“ -SSLOffloading $false

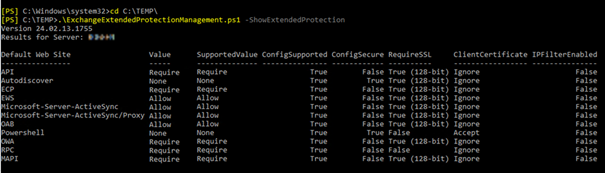

Um den Erfolg des Scripts zu prüfen, kann erneut mit dem Parameter -ShowExtendedProtection die Konfiguration geprüft werden. Diese sollte nun wie folgt aussehen:

Wichtig ist, dass nach der Anpassung die Funktionen geprüft werden. Hierzu sollten überprüft werden ob OWA und ECP sowie die Management-Shell, als auch die Outlook Verbindungen von Intern und Extern funktionieren.

Sollte es zu Problemen kommen, kann die Konfiguration wieder auf den Ursprungszustand zurückgesetzt werden. Dafür können folgenden Befehle genutzt werden:

C:\TEMP\.ExchangeExtendedProtectionManagement.ps1 -RollbackType „RestoreIISAppConfig“

C:\TEMP.\ExchangeExtendedProtectionManagement.ps1 -RollbackType „RestrictTypeEWSBackend“

Diese Befehle setzen die Einstellungen in Front- und BackEnd wieder zurück. Die Sicherheitslücke bleibt allerdings dann auch bestehen.

Sollte beim Rollback ein Fehler auftreten aufgrund fehlender Backup-Files, kann per folgendem Befehl ein kompletter Rollback durchgeführt werden.

.\ExchangeExtendedProtectionManagement.ps1 -DisableExtendedProtection

Fazit:

Vor Aktivierung der Extended Protection sollten alle Voraussetzungen geprüft werden (TLS-Einstellungen, Updatestand, TLS-Offloading auf Loadbalancer, etc.). Wenn diese alle passen, sollte es bei der Aktivierung keine Probleme geben. Sollten dennoch Probleme auftreten, kann die Einstellungen relativ schnell wieder zurückgesetzt werden. Aufgrund der derzeitigen Sicherheitslücke empfehlen wir allerdings, die Extended Protection schnellstmöglich zu aktivieren!